|

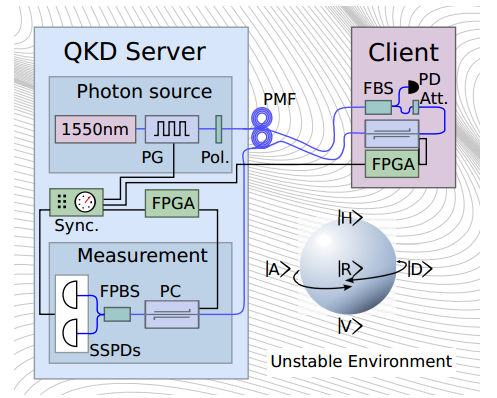

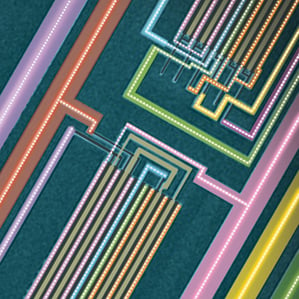

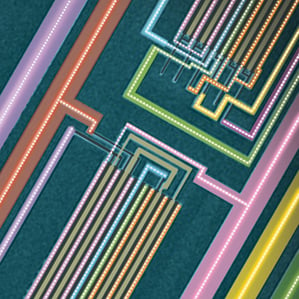

Esta imagen de microscopía electrónica de barrido

muestra una sección del 1er ordenador de nanotubos de

carbono. La imagen ha sido coloreada para identificar

las diferentes partes del chip |

Un procesador de ordenador hecho de nanotubos de carbono es comparable a un chip de la década de los 70, y podría ser el primer paso para ir más allá de la electrónica de silicio.

POR KATHERINE BOURZAC TRADUCIDO POR FRANCISCO REYES (OPINNO)

Por primera vez, un grupo de investigadores ha construido un ordenador cuyo procesador central está basado enteramente en nanotubos de carbono, una forma de carbono con notables propiedades electrónicas y de material. El ordenador es lento y simple, pero sus creadores, un grupo de ingenieros de la Universidad de Stanford (EE.UU.), aseguran que demuestra que la electrónica de nanotubos de carbono supone un potencial y viable reemplazo para el silicio cuando este alcance su límite en los circuitos electrónicos, que cada vez son más pequeños.

El procesador de nanotubos de carbono es comparable en capacidad al Intel 4004, el primer microprocesador de dicha compañía lanzado en 1971, afirma

Subhasish Mitra, ingeniero eléctrico de Stanford y uno de los colíderes del proyecto. El ordenador, descrito en la revista Nature, ejecuta un sencillo conjunto de instrucciones de software llamado MIPS. Puede llevar a cabo diversas tareas (contar y clasificar números) y realizar un seguimiento de las mismas, además de recuperar datos de una memoria externa, y volverlos a escribir en ella.

El procesador de nanotubos se compone de 142 transistores, cada uno de los cuales contiene nanotubos de carbono de alrededor de 10 a 200 nanómetros de largo. El grupo de Stanford afirma que ha creado seis versiones de ordenadores de nanotubos de carbono, entre ellos uno que puede ser conectado a hardware externo, como un teclado numérico para introducir números a sumar.

Aaron Franklin, investigador del Centro de Investigación Watson de IBM en Yorktown Heights, Nueva York, señala que la comparación con los procesadores 4004 y otros parecidos de silicio resulta acertada. "Esta es una demostración excelente para aquellas personas en la comunidad electrónica que hayan dudado de los nanotubos de carbono", afirma.

El grupo de Franklin ha demostrado que los transistores de nanotubos de carbono individuales, de menos de 10 nanómetros, son más rápidos y más eficientes energéticamente que los fabricados con cualquier otro material, como por ejemplo el silicio. El trabajo teórico también ha sugerido que un ordenador de nanotubos de carbono sería una orden de magnitud más eficiente en cuanto a la energía que los mejores ordenadores de silicio. Además, la capacidad del nanomaterial para disipar el calor sugiere que los ordenadores de nanotubos de carbono podrían ser vertiginosamente rápidos sin calentarse, un problema que fija los límites de velocidad en los procesadores de silicio de los ordenadores actuales.

Sin embargo, algunas personas dudan de que los nanotubos de carbono puedan sustituir al silicio. Trabajar con nanotubos de carbono es un gran reto. El modo habitual de cultivarlos hace que acaben formando una maraña, y alrededor de un tercio de los tubos son metálicos, en lugar de semiconductores, lo que provoca cortocircuitos.

En los últimos años, Mitra ha colaborado con el ingeniero eléctrico de Stanford

Philip Wong, que ha desarrollado formas de eludir algunas de las dificultades materiales que han impedido la creación de complejos circuitos de nanotubos de carbono. Wong ha desarrollado un método para el cultivo de nanotubos mayoritariamente rectos sobre cuarzo, para a continuación, transferirlos a un sustrato de silicio con el que crear los transistores. El grupo de Stanford también cubre las áreas activas de los transistores con una capa protectora, y después elimina todos los nanotubos expuestos que no se hayan creado correctamente.

Wong y Mitra también aplican voltaje para hacer que todos los nanotubos semiconductores en un chip pasen a posición 'off'. Luego pulsan una gran cantidad de corriente a través del chip: los metálicos se calientan, se oxidan y se desintegran. Todas estas correcciones específicas en los nanotubos, así como el resto del proceso de fabricación, se pueden realizar con los equipos estándar que se utilizan para hacer chips de silicio hoy día. En ese sentido, el proceso es escalable.

A finales del mes pasado en

Hot Chips, una conferencia de ingeniería de diseño que tuvo lugar, casualmente, en Stanford, el director de la Oficina de Tecnología de Microsistemas de la agencia estadounidense DARPA provocó un gran revuelo al discutir el final de la electrónica de silicio. Durante su discurso,

Robert Colwell, exarquitecto jefe de Intel, predijo que incluso en 2020 la industria de la computación ya no será capaz de seguir haciendo mejoras de rendimiento y coste duplicando la densidad de los transistores de silicio en los chips cada 18 o 24 meses, una hazaña conocida como la ley de Moore después de que el cofundador de Intel, Gordon Moore, observara por primera vez la tendencia.

Mitra y Wong esperan que su ordenador muestre que los nanotubos de carbono pueden ser una respuesta seria a la cuestión del reemplazo del silicio. Hasta el momento ninguna nueva tecnología emergente se acerca mínimamente al silicio. De todos los materiales emergentes y nuevas ideas consideradas como posibles salvadores (los nanocables, la espintrónica, el grafeno, los ordenadores biológicos), nadie ha creado una unidad central de proceso basada en ninguno de ellos, afirma Mitra. En ese contexto, ponerse al día con el rendimiento que tenía el silicio alrededor de 1970, a pesar de suponer que aún queda mucho trabajo por hacer, resulta emocionante.

Victor Zhirnov, especialista en nanoelectrónica en

Semiconductor Research Corporation, con sede en Durham, Carolina del Norte (EE.UU.), es optimista pero mantiene la cautela. El procesador de nanotubos posee 10 millones de veces menos transistores que los microprocesadores típicos de hoy día, funciona mucho más lentamente y usa un voltaje cinco veces mayor, lo que significa que utiliza una cantidad de energía casi 25 veces más alta, señala.

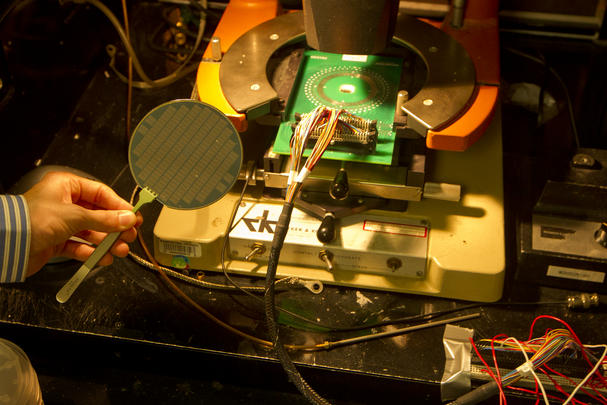

Parte de la lentitud del ordenador de nanotubos se debe a las condiciones en las que ha sido construido: en un laboratorio académico y usando aquello a lo que el grupo de Stanford tenía acceso, y no en una fábrica estándar de la industria. El procesador está conectado a un disco duro externo, que sirve como memoria, a través de un gran paquete de cables eléctricos, cada uno de los cuales se conecta a un pasador metálico de grandes dimensiones en la parte superior del procesador de nanotubos. Cada uno de los pasadores a su vez se conecta a un dispositivo en el chip. Este embalaje tan torpe hace que los datos tengan que viajar distancias más largas, lo que reduce la eficiencia del ordenador.

Con las herramientas que tienen a mano, el grupo de Stanford tampoco puede crear transistores con dimensiones menores a aproximadamente un micrómetro. Esto hay que compararlo con el anuncio de Intel a principios de mes de que su próxima línea de productos se basará en tecnología de 14 nanómetros. Sin embargo, si el grupo tuviera acceso a una fábrica de última generación, los rendimientos de fabricación mejorarían lo suficiente como para ser capaces de crear ordenadores con miles de transistores más pequeños, y el ordenador podría funcionar más rápido.

Para alcanzar el extraordinario nivel de rendimiento teórico ofrecido por los nanotubos, los investigadores tendrán que aprender a construir circuitos integrados complejos hechos de transistores de nanotubos prístinos e individuales. Franklin señala que los expertos de dispositivos y materiales, como su grupo en IBM, tienen que empezar a trabajar en colaboración más estrecha con diseñadores de circuitos como los de Stanford para hacer progresos reales.

"Somos muy conscientes de que el silicio está perdiendo fuerza, y dentro de 10 años tocará a su fin", afirma Zhirnov. "Para que los nanotubos de carbono sean prácticos, tienen que empezar a usarse rápidamente". MIT